SLAM: 로봇이 알려지지 않은 지형을 탐색하는 방법

낯선 사막에 고립되어 안전한 곳으로 가는 길을 찾아야 하는 어려운 상황에 직면했다고 상상해 보세요. 낯선 지형을 탐색하는 것은 인간과 로봇 모두에게 오랫동안 어려운 과제였습니다. 로봇 또는 자율 주행 차량을 위한 일반적인 내비게이션 방법에는 기존 지도가 필요하지만, 지도 상에 표시되어 있지 않은 지역의 경우 해당 영역을 횡단하지 않고는 이러한 지도를 구할 수 없습니다. 이는 로보틱스에서 '닭이 먼저냐 달걀이 먼저냐'의 문제로 일컬어지는 전통적인 딜레마를 나타냅니다. 지도 없이 로봇이 어떻게 미지의 환경에서 길을 찾을 수 있을까요? 또는, 환경을 탐색하지 않고 어떻게 지도를 만들 수 있을까요?

3D 비주얼 SLAM 지도 또는 비주얼 SLAM을 사용하여 만든 SLAM 지도. (www.flyability.comImage source: Sigmoidal.ai에서 재현됨)

3D 비주얼 SLAM 지도 또는 비주얼 SLAM을 사용하여 만든 SLAM 지도. (www.flyability.comImage source: Sigmoidal.ai에서 재현됨)

여기서 SLAM(Simultaneous Localization and Mapping)의 개념이 등장합니다. Hugh Durrant-Whyte와 John J. Leonard와 같은 연구자들이 개발한 SLAM은 로봇이 실시간으로 미지의 환경을 자율적으로 탐색하고 매핑할 수 있는 기술입니다. SLAM을 사용하면 로봇이 기존 지도에 의존하지 않고 주변 지도를 생성하는 동시에 해당 지도 내에서 자신의 위치를 파악할 수 있습니다. SLAM의 중심에는 두 가지 주요 프로세스인 매핑 및 로컬라이제이션이 있습니다. 매핑은 환경의 공간적 표현을 생성하는 것을 의미하고, 로컬라이제이션은 해당 지도 내에서 로봇의 위치를 결정하는 것을 포함합니다. 이러한 프로세스는 센서 데이터를 기반으로 하여 지도를 지속적으로 업데이트하고 그에 따라 위치 추정을 조정하는 로봇과 밀접하게 관련되어 있습니다.

SLAM을 구현하는 데는 여러 주요 단계가 포함되며 각각 전체 프로세스에 결정적 역할을 수행합니다. 이러한 단계에는 랜드마크 추출, 데이터 연관, 상태 추정 및 업데이트가 포함됩니다. 랜드마크 추출 단계에서는 환경에서 매핑 및 로컬라이제이션을 위한 참조점으로 사용할 수 있는 뚜렷한 특징 또는 랜드마크를 식별해야 합니다. 데이터 연관 단계에는 센서 측정값을 지도의 특징에 일치시키는 과정이, 상태 추정 단계에는 센서의 데이터를 기반으로 하여 로봇의 위치 및 방향을 추정하는 과정이 필요합니다. 마지막으로 업데이트 단계에는 새로운 센서 측정값을 기반으로 하는 지도 및 위치를 추정하는 작업이 필요합니다.

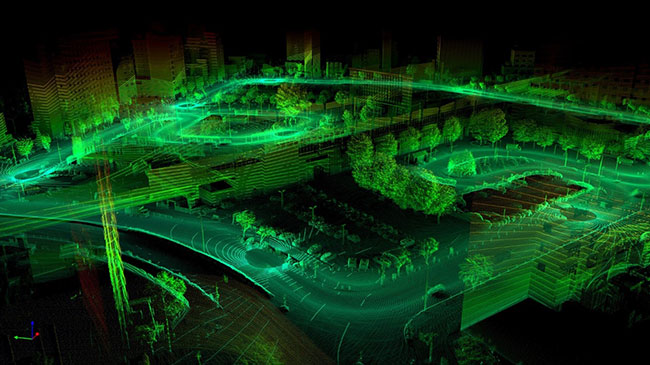

SLAM의 유효성을 결정하는 핵심 요인 중 하나는 사용되는 센서의 유형입니다. 센서마다 결과로 생성되는 지도 및 로컬라이제이션 추정의 품질에 영향을 미칠 수 있는 다양한 수준의 정확도 및 정보를 제공합니다. 예를 들어, 비주얼 SLAM(vSLAM)은 1차 센서로 카메라를 사용하여 로봇이 주변 환경에서 시각적 정보를 추적할 수 있도록 합니다. 이 비주얼 정보에는 에지, 코너, 텍스처와 같이 매핑 및 로컬라이제이션을 위한 랜드마크로 사용할 수 있는 특징이 포함될 수 있습니다. 또한, 카메라는 객체 감지 및 인지와 같이 작업을 지원할 수 있는 풍부한 의미론적 정보를 제공합니다. 반면, LiDAR 기반 SLAM은 레이저 빔을 방출하여 해당 환경에서 물체까지의 거리를 측정하는 LiDAR 센서(예: SparkFun의 SLAMTEC SEN-15870)를 활용합니다. LiDAR 센서는 높은 정확도와 정밀도를 제공하여 기하학적 구조가 복잡한 환경을 매핑하는 데 매우 적합합니다. 그러나 LiDAR 센서는 돈이 많이 들고 계산 집약적이므로 특정 시나리오에서 응용 가능성이 제한될 수 있습니다.

사용되는 카메라의 유형에 따라 vSLAM의 하위 카테고리에는 여러 가지가 있습니다. 여기에는 단안 SLAM, 스테레오 SLAM, RGB-D SLAM이 포함됩니다. 단안 SLAM은 하나의 카메라를 사용하여 로봇의 움직임과 환경 구조를 추정합니다. 스테레오 SLAM은 두 개의 카메라가 서로 기준 거리만큼 떨어져 위치한 스테레오 카메라 설정을 사용합니다. 이러한 설정을 통해 시각적 특징을 삼각분할할 수 있으므로 향상된 깊이 추정과 매핑 정확도를 실현할 수 있습니다. 마지막으로, RGB-D SLAM은 기존의 RGB 카메라와 깊이 센서(예: Microsoft Kinect 또는 Intel RealSense 카메라)를 결합합니다. 이러한 추가 깊이 정보를 통해 보다 정확한 3D 매핑 및 로컬라이제이션을 실현할 수 있습니다.

vSLAM의 각 하위 카테고리에는 비용, 계산 복잡도, 환경 조건과 같은 요인에 따라 달라지는 고유한 이점 및 제한이 있습니다. 예를 들어 단안 SLAM은 단순하고 비용이 저렴하므로 널리 사용됩니다. 그러나 환경의 스케일을 직접 추정할 수 없으므로 스케일 모호성으로 인한 어려움이 있습니다. 스테레오 SLAM은 비주얼 특징의 삼각분할을 활용하여 깊이 및 스케일을 추정함으로써 이러한 문제를 해결합니다. 한편 RGB-D SLAM은 RGB 영상 및 깊이 정보의 결합 덕분에 가장 높은 수준의 정확도와 세부 정보를 제공합니다.

로보틱스 분야의 응용 제품뿐만 아니라 SLAM은 다양한 산업에 걸쳐 여러 응용 제품에 실제로 사용되고 있습니다. 로보틱스의 경우 SLAM은 로봇이 창고, 공장, 재난 영역과 같은 동적 환경을 자동으로 탐색하도록 합니다. 자율 주행 차량의 경우 SLAM은 도로에 대한 고화질 지도를 생성하고 해당 지도 내에서 차량의 위치를 찾는 데 사용됩니다. SLAM은 증강 현실(AR)과 가상 현실(VR)에도 적용되어 가상 객체를 실제 환경에 오버레이하여 몰입감 있는 체험을 실현하는 데 사용됩니다.

이러한 여러 이점을 가진 SLAM에도 결점은 있습니다. SLAM의 주요 문제 중 하나는 센서 데이터를 처리하고 지도를 실시간으로 업데이트하는 작업과 관련된 계산 복잡도입니다. 이는 대량의 데이터 또는 제한적 계산 리소스가 사용되는 환경에서 특히 문제가 될 수 있습니다. 또한, SLAM은 환경에 뚜렷한 특징 및 랜드마크가 있는지 여부에 따라 영향을 상당히 많이 받습니다. 환경이 균일적이거나 지형에 특색이 없는 경우 SLAM은 정확한 지도를 생성하거나 로봇을 효율적으로 로컬라이제이션하기가 쉽지 않을 수 있습니다.

결론적으로, 동시 로컬라이제이션 및 매핑(SLAM)은 로봇이 알려지지 않은 환경을 자동으로 탐색하고 실시간으로 매핑할 수 있는 강력한 기술입니다. 매핑 및 로컬라이제이션을 단일 프로세스에 통합함으로써 SLAM은 로봇이 사전 지식이나 기존 지도 없이도 주변 환경을 탐색하고 이해할 수 있습니다. SLAM에는 고유한 과제와 한계가 있으며 로보틱스, 자율 주행 차량, AR 및 VR과 같은 산업에 걸쳐 광범위하고 다양하게 응용할 수 있습니다. 기술이 계속 발전함에 따라 SLAM은 로보틱스 및 자동화의 미래를 형성하는 데 점점 더 중요한 역할을 하고 있습니다.

참고 자료:

- SLAM이란?(동시 로컬라이제이션 및 매핑) (vercator.com)

- SLAM 소개(동시 로컬라이제이션 및 매핑) | Ouster

- 30분 만에 SLAM 이해하기: 대화형 워크숍 | Ouster

- SLAM 이란(동시 로컬라이제이션 및 매핑) - MATLAB & Simulink - MATLAB & Simulink(mathworks.com)

- SLAM, 정의 및 에볼루션 - ScienceDirect

- SLAM에 사용되는 주요 알고리즘 소개 - 기술 관련 기사(control.com)

- 로컬라이제이션 - 로봇틱스 및 개념 소개(roboticsbook.org)

Have questions or comments? Continue the conversation on TechForum, Digi-Key's online community and technical resource.

Visit TechForum